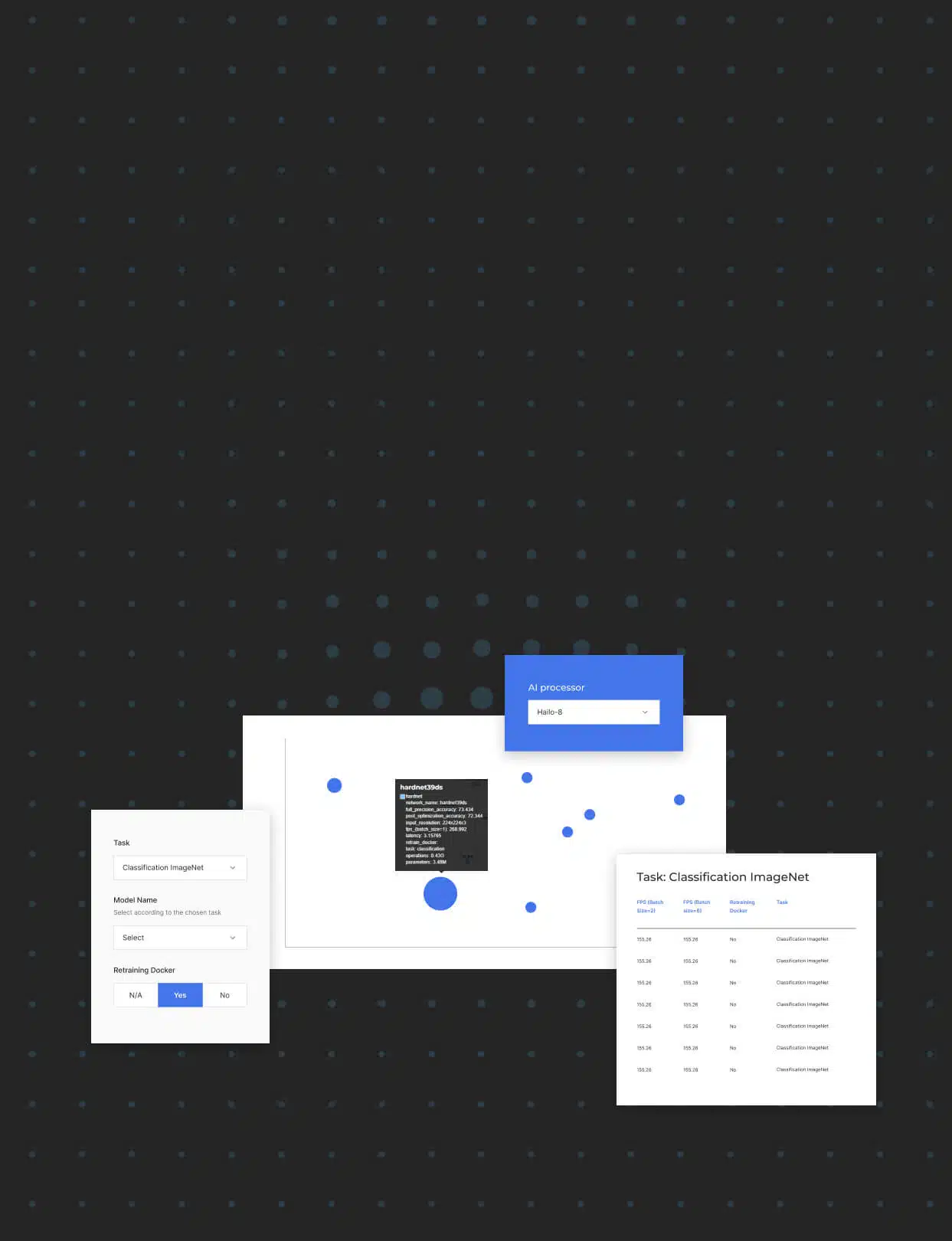

Das Hailo Modell Explorer ist ein dynamisches Tool, das den Benutzern hilft, die Modelle im Modell Zoo zu erkunden und die besten NN-Modelle für ihre KI-Anwendungen auszuwählen.

Mit dem Modell Zoo können Benutzer schnell und einfach die von Hailo veröffentlichte Leistung auf den in unserem Modell Zoo enthaltenen gängigen Modellen und Architekturen reproduzieren und diese Modelle neu trainieren. Die Sammlung umfasst sowohl gängige als auch moderne Modelle, die in den Formaten TensorFlow und ONNX verfügbar sind.

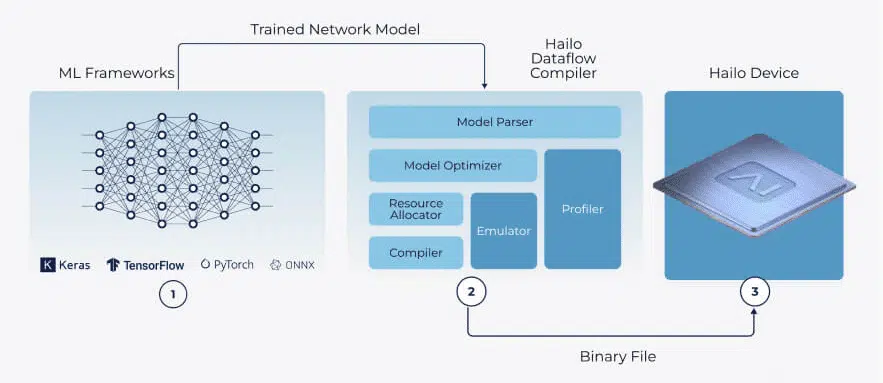

Die vortrainierten Modelle können für ein schnelles Prototyping auf Hailo-Geräten verwendet werden. Jedes Modell wird von einer binären HEF-Datei begleitet, die von der Hailo-Toolchain und der Anwendungssuite (nur für registrierte Benutzer zugänglich) vollständig unterstützt wird.

Die Auswahl eines geeigneten Modells für Ihre Anwendung kann aufgrund verschiedener Faktoren wie Inferenzgeschwindigkeit, Modellverfügbarkeit, gewünschte Genauigkeit, Lizenzierung usw. schwierig sein. Die Inferenzgeschwindigkeit ist einzigartig, da sie ohne die zugrunde liegende Hardware nicht einfach geschätzt werden kann.

Die Auswahl eines geeigneten Modells für Ihre Anwendung kann aufgrund verschiedener Faktoren wie Inferenzgeschwindigkeit, Modellverfügbarkeit, gewünschte Genauigkeit, Lizenzierung usw. schwierig sein. Die Inferenzgeschwindigkeit ist einzigartig, da sie ohne die zugrunde liegende Hardware nicht einfach geschätzt werden kann.

Der untenstehende Modell Explorer wurde entwickelt, um den Benutzern zu helfen, besser informierte Entscheidungen zu treffen und so eine maximale Effizienz auf der Hailo Plattform zu gewährleisten. Der Modell Explorer bietet eine interaktive Schnittstelle mit Filtern, die auf Hailo-Geräten, Aufgaben, Modellen, FPS und Genauigkeit basieren und es dem Benutzer ermöglichen, zahlreiche NN-Modelle aus der umfangreichen Bibliothek von Hailo zu untersuchen.

Lesen Sie im Hailo Blog mehr darüber, wie das Hailo Modell Zoo funktioniert und was es kann.